Las redes sociales fueron sacudidas esta semana por la propagación de imágenes pornográficas generadas por inteligencia artificial (IA) de Taylor Swift, la mundialmente famosa estrella pop. Este incidente destaca la creciente preocupación en torno a la tecnología de IA, que posee la capacidad de crear imágenes convincentemente reales y perjudiciales.

Las imágenes falsas de Swift se difundieron principalmente en la red social X, anteriormente conocida como Twitter. A pesar de haber sido retiradas después de acumular decenas de millones de visualizaciones, persiste el riesgo de que resurjan en canales menos regulados, ya que nada en Internet desaparece definitivamente.

El portavoz de Taylor Swift no ha emitido comentarios sobre el incidente hasta el momento. Mientras tanto, las políticas de X, al igual que otras plataformas de medios sociales, prohíben compartir contenido “sintético, manipulado o fuera de contexto que pueda engañar o confundir a la gente y causar daños”.

Ben Decker, director de Memetica, una agencia de investigación digital, destacó que este evento es un claro ejemplo de cómo la inteligencia artificial se utiliza con fines perjudiciales, subrayando la falta de salvaguardias efectivas para proteger la esfera pública.

El contexto político actual en Estados Unidos, con elecciones presidenciales en el horizonte, aumenta la preocupación sobre el posible uso de imágenes y videos generados por IA para campañas de desinformación que podrían interferir con el proceso electoral.

El incidente también resalta las deficiencias en las políticas de moderación de contenido de algunas plataformas sociales. X ha reducido significativamente su equipo de moderación, confiando en sistemas automatizados y en informes de usuarios, lo que plantea dudas sobre la efectividad de tales enfoques.

La procedencia de las imágenes de Taylor Swift aún no está clara. Aunque algunas se encontraron en sitios como Instagram y Reddit, la propagación fue especialmente notoria en la plataforma X.

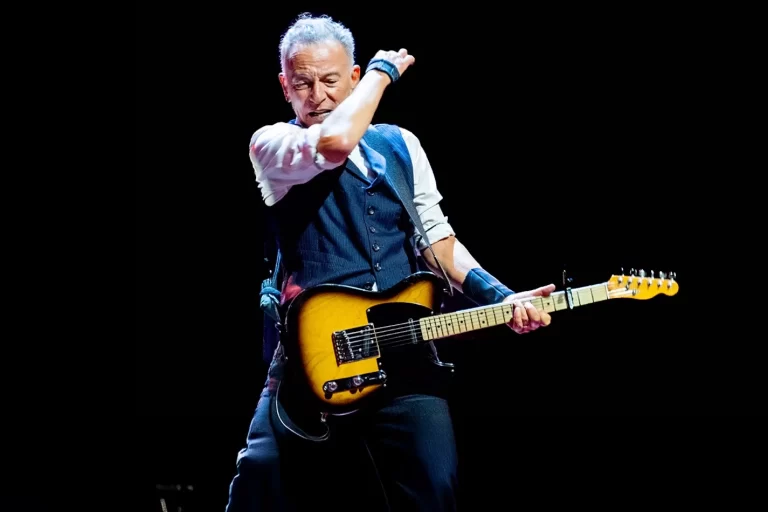

Generación de IA

Este episodio coincide con el auge de herramientas de generación de IA, como ChatGPT y Dall-E. Sin embargo, Decker advierte sobre la existencia de modelos de IA no moderados y no seguros en plataformas de código abierto, que pueden ser utilizados de manera perjudicial.

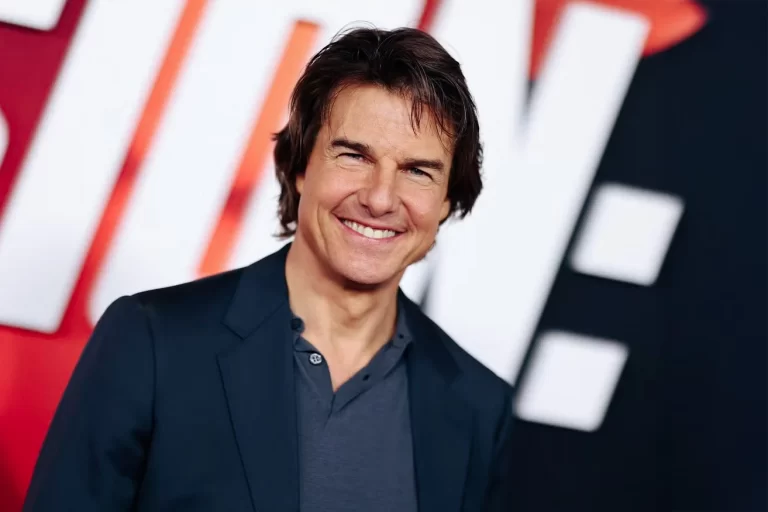

La atención pública que ha generado este incidente podría impulsar acciones legislativas y cambios en las políticas de las empresas tecnológicas. Decker sugiere que, al igual que ocurrió con la reforma en las políticas de venta de entradas después del colapso de Ticketmaster en 2022, la difusión de imágenes perjudiciales generadas por IA podría convertirse en un tema prioritario.

“Cuando figuras como Taylor Swift se convierten en un blanco tan importante, quizá sea esto lo que impulse a los legisladores y a las empresas tecnológicas a actuar”, afirma Decker. “No pueden permitirse que la ‘novia de Estados Unidos’ haga una campaña pública en su contra, ya que probablemente tiene más influencia que casi cualquier otra persona en Internet”.

La tecnología de IA ha sido utilizada durante mucho tiempo para crear “porno de venganza”, pero la atención renovada a raíz de las imágenes ofensivas de Swift destaca la necesidad de una regulación más estricta. En la actualidad, nueve estados de EE.UU. cuentan con leyes contra la creación o el intercambio no consentido de imágenes “deepfake”, que son imágenes artificiales creadas para imitar la propia imagen de una persona.